GPUサーバーとは? 導入するメリットや主な用途、選ぶポイントを解説【トゥモロー・ネット テックブログ】

近年、ディープラーニングなど大量のデータ処理を必要とする分野で、「GPUサーバー」の活用が進んでいます。しかし、GPUサーバーとは何なのかがわからず、導入に二の足を踏んでいる方も多いのではないでしょうか。

そこで今回の記事では、GPUサーバーとは何かという概要から、導入するメリットや主な用途、製品を選ぶうえでのポイントなどについて、詳しく解説します。

GPUサーバーの導入を検討している方は、ぜひご参考ください。

そもそもGPUとは何か

GPUとは “Graphics Processing Unit” の頭文字を取ったもので、PCに搭載される半導体チップの1つです。GPUを日本語にすると「グラフィックス処理装置」という意味になり、名前の通り画像や映像の処理を行うことを目的として搭載されていますが、ある種の計算処理においては非常に優れた能力を発揮するハードウェアの一部です。

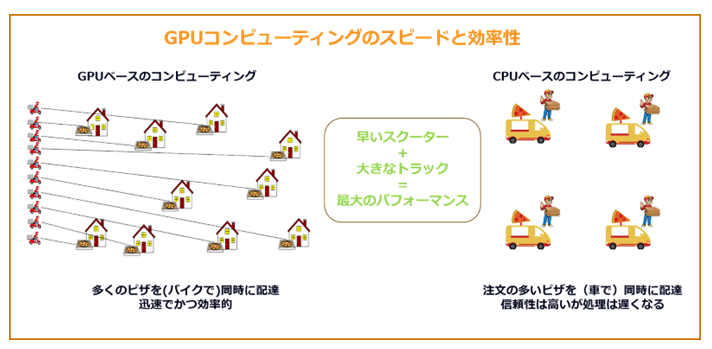

PCに搭載される半導体チップというとCPU(Central Processing Unit)が有名ですが、CPUが連続的な計算処理を行う一方で、GPUは最大数千もの軽量化されたコアで構成され、すべてのコアが並列にデータの計算処理を実施します。そのため、CPUとGPUをあわせて利用することで、処理速度を大幅に向上させられるのです。

その結果、GPUは画像・映像処理だけでなく、PCで行う計算処理全般に多く利用されるようになりました。

GPUサーバーとは

GPUサーバーとは、名前の通りGPUを搭載したサーバー設備のことです。先述の通り、PCには通常GPUが既に搭載されていますが、その処理できるキャパシティには限界があります。そのため、膨大な量の計算が必要とされるシーンにおいては、PCとGPUサーバーを繋げることで、より高い処理能力を実現させられます。

GPUサーバーを1台導入すれば、会社で使うPC全体の処理速度を劇的に向上させられます。そのため、データーセンター、製造、流通業界をはじめ、多くの業界で導入が進んでいます。

GPUサーバーの種類

ひとくちにGPUサーバーといっても、大きく分けて「オンプレミス型」「クラウド型」があります。

ここでは、それぞれの特徴や違いについて、詳しく確認していきましょう。

種類①:オンプレミス型

オンプレミス型とは、販売会社(ベンダー)から購入するタイプのGPUサーバーです。

ベンダーから購入するため、自社のニーズに合わせてカスタマイズできる点が魅力でしょう。また、サーバー機器を自社施設内に設置できるので、インフラ管理やセキュリティ性の確保がしやすい点も特徴といえます。

ただし、オンプレミス型の場合は、購入のために初期投資額が高くなりやすい点に注意が必要です。

種類②:クラウド型

クラウド型とは、自社にサーバー機器を設置せず、インターネット経由で利用するタイプのGPUサーバーです。

クラウド型は、インターネット環境さえあれば、どこからでもGPUサーバーが利用できる点が魅力です。また、管理や保守もベンダー側で対応をしてくれるので、自社のリソース削減にもなります。

ただし、クラウド型はレンタル型と同様に、長期的に見るとランニングコストが高くなる可能性があります。また、インターネット環境が必須なので、オフラインでの作業時には使えない点にも注意が必要です。

GPUサーバーを使うメリット

GPUサーバーを利用すると、多くのメリットを得られます。

ここでは、代表的な3つのメリットについて、詳細を確認していきましょう。

メリット①:大規模なデータ処理の実現

GPUサーバーを利用すると、大規模なデータ処理が可能になります。

通常、PCで作業する際はCPUがデータ処理の中心を担い、GPUがそれをサポートします。しかし、データが大規模になると処理負荷が増大し、CPUと搭載されたGPUだけでは処理に限界が生じます。

ここでGPUサーバーを利用することで、内蔵GPUのリソースを気にせずに、常にスムーズなデータ処理が可能となります。

メリット②:処理速度の高速化

GPUサーバーを利用すると、PCでの処理速度を高速化させられます。

特にAI開発やディープラーニングなどの分野では、大量のデータを一度に扱うため、PC単体では処理にかかる時間が長くなりやすいです。しかし、GPUサーバーに繋いでいれば、大幅に処理時間を短縮させられるでしょう。

メリット③:CPUの負担軽減

GPUサーバーを利用することで、CPUの負担を軽減させられます。

一般的に、CPUは複雑な作業や連続的な処理を得意としますが、処理するデータ量が増えると限界が生じ、それらのタスクに遅延が生じます。その点、GPUサーバーを導入すれば、処理するデータ量が増えてもCPUに負担をかけず、常にスムーズな作業を実現させられるでしょう。

GPUサーバーの主な用途

GPUサーバーは、幅広い現場で活用されています。

ここでは、中でも代表的な3つの用途について、詳しく確認していきましょう。

用途①:AI / 機械学習

近年大きな話題を集めるAI開発や機械学習では、大量のデータを高速に処理することが求められます。その際、GPUサーバーを利用すれば、並列処理能力を大幅に向上させられます。そのため、さまざまなAI開発、機械学習のアルゴリズムに活用されています。

用途②:仮想デスクトップ

GPUサーバーは、仮想デスクトップで作業をする際にもよく使われます。仮想デスクトップは、複数の作業を並行して同時に行うために使われますが、その効率性や快適性はGPUの処理速度に大きく依存します。GPUサーバーを利用すれば、複数人でリモート作業したとしても、スムーズに作業を進められるでしょう。

用途③:研究開発

GPUサーバーは、研究開発の現場でも役立っています。たとえば、生命科学(ゲノム)の解析や、気象モデリングなどでは、複雑な計算が必要となりますが、GPUサーバーがあれば、正確な結果をスムーズに得られるでしょう。

用途④:3Dレンダリング

GPUサーバーは、映像やゲーム、建築デザインの制作などで使われる3Dレンダリングにも活用されています。GPUサーバーがあれば、高品質な画像や映像がスムーズに生成できるので、大規模なプロジェクトであっても、効率的に作業を進められるでしょう。

GPUサーバーを選ぶポイント

ここでは、GPUサーバーを選ぶ際に重視したいポイントを3点ご紹介します。

これからGPUサーバーの導入を検討している方は、ぜひ参考にしてください。

ポイント①:コストパフォーマンス

どんなに高性能なGPUサーバーであっても、その性能を使い切れないのでは意味がありません。オーバースペックにならないよう、コストパフォーマンス性に優れた製品を選ぶようにしましょう。

ポイント②:拡張性

GPUサーバーの導入後、事業拡大などの影響で、必要スペックが増えることがしばしばあります。その際、搭載メモリ数やストレージなどを拡張できるタイプを選んでおけば、新たに買い替えずに済むようになります。

ポイント③:冷却性能

GPUサーバーは大きな負荷がかかるため、サーバーに熱がこもりやすくなります。その際、熱を上手く逃がせないと早期故障の原因になるので、水冷や空冷など、冷却機能に優れたものを選ぶことも重要なポイントです。

トゥモロー・ネットのGPUサーバー

ここでは、トゥモロー・ネットが取り扱われているGPUサーバーの一部について紹介します。

NVIDIA H200 Tensor Core GPU

NVIDIA H200 Tensor コア GPUは、HBM3eメモリを搭載した初のGPUで大容量かつ高速なメモリを提供し、科学コンピューティングによるHPCワークロードの推進と、生成AIや大規模言語モデル(LLM)の高速化を実現します。Llama 2のようなLLMを処理する際、従来のH100 GPUと比較して推論速度を最大2倍に向上させ、企業がより迅速に洞察を得られるよう支援します。

NVIDIA H200 Tensor Core GPU製品の詳細はこちら

NVIDIA H100 Tensor Core GPU

NVIDIA H100 Tensor Core GPUはあらゆるデータ センターにかつてない性能、拡張性、セキュリティを提供し、あらゆるワークロードに対応します。H100を搭載したサーバーは、GPUごとに毎秒3テラバイトのメモリ帯域幅を提供し、NVLinkとNVSwitchを使用することで高いスケーラビリティを実現します。これにより、膨大なデータセットに対する高性能なデータ分析が可能になります。

NVIDIA H100 Tensor Core GPU製品の詳細はこちら

NVIDIA L40 GPU

NVIDIA L40 GPUは、最新世代のRT、Tensor、およびCUDAコアのパワーを活用し、最も厳しいデータセンターワークロードに対して優れたビジュアライゼーションとコンピューティングパフォーマンスを提供します。電力効率に優れたハードウェアとコンポーネントを使用して設計されており、24時間365日のエンタープライズデータセンター運用に最適化されています。

NVIDIA L4 GPU

NVIDIA L4 GPUはビデオ、AI、グラフィックスを効率的に実現します。薄型フォームファクターで設計されたL4は、エッジ、データセンター、クラウドを含むすべてのサーバーにおいて、費用対効果が高く、エネルギー効率に優れたソリューションを実現し、高いスループットと低遅延を提供します。

まとめ

今回は、GPUサーバーについて、概要や導入するメリット、主な用途などについて詳しく確認してきました。GPUサーバーはPCの処理速度を大幅に拡張させられる設備です。そのため、AI開発や科学研究など幅広い分野で導入が進んでいます。

これからGPUサーバーの導入を行う方には、世界のAI技術をリードするNVIDIA社のGPU製品とSupermicro社のサーバーを組み合わせたGPUサーバーがおすすめです。NVIDIA社のパワフルなGPUシステムは、AI開発や科学研究、3Dレンダリングなどの用途でご活用いただいています。

トゥモロー・ネットでは、NVIDIA社、Supermicro社とのパートナーシップを結んでおり、GPUサーバーを1,000台以上導入してきた実績があります。

Supermicro社 と正規一次代理店トゥモロー・ネットのパートナーシップ

NVIDIA認定パートナーに贈られるNVIDIA Partner Network Award 2023にて「Rising Star Award」を受賞

NVIDIAとパートナー契約を締結しパートナープログラムの最上位レベル「Elite Partner」に認定

その他にも、AIインフラの選定・設計・構築・保守までを、ワンストップでサポートさせていただきます。GPUサーバーの導入をご検討の方は、ぜひお気軽にお問い合わせください。

Supermicro製 GPUサーバーの特徴や仕様についてはこちら

関連記事

クラウドコンピューティングとは?仕組みやメリット・デメリットを解説

この記事の筆者

株式会社トゥモロー・ネット

クラウドソリューション本部

製品のお問い合わせはこちらから

トゥモロー・ネットは「ITをもとに楽しい未来へつなごう」という経営理念のもと、感動や喜びのある、より良い社会へと導く企業を目指し、最先端のテクノロジーとサステナブルなインフラを提供しています。設立以来培ってきたハードウェア・ソフトウェア製造・販売、運用、保守などインフラに関わる豊富な実績と近年注力するAIサービスのコンサルティング、開発、運用、サポートにより、国内システムインテグレーション市場においてユニークなポジションを確立しています。

インフラからAIサービスまで包括的に提供することで、システム全体の柔軟性、ユーザビリティ、コストの最適化、パフォーマンス向上など、お客様の細かなニーズに沿った提案を行っています。

カテゴリー

タグ

- #ストレージ(ソフト)

- #VMware

- #Veeam Backup & Replication

- #AIインフラ

- #AMD EPYC

- #スケールアウトNAS

- #NVIDIA H200

- #NIC

- #LLM

- #AI

- #エンタープライズ

- #NVIDIA

- #NVMe

- #画像生成AI

- #コア

- #スケールアップ

- #NVIDIA A800

- #Ethernet

- #水冷サーバー

- #CPU

- #GPU

- #グリーンコンピューティング

- #SSD

- #NVIDIA H100

- #スレッド

- #スケールアウト

- #NVIDIA L40

- #Network

- #NVIDIA RTX 6000 Ada

- #Supermicro

- #GPUサーバー

- #グリーンIT

- #SAS SSD

- #ソフトウェア・デファインド・ストレージ

- #クロック周波数

- #Qumulo

- #SXM

- #InfiniBand

- #NVIDIA RTX A6000

- #Intel

- #マイグレーション

- #空冷

- #SATA SSD

- #Seagate

- #ECCメモリ

- #RedHat

- #PCle

- #NVIDIA MIG

- #量子コンピューター

- #AMD

- #レガシーアプリ

- #水冷

- #NVMe SSD

- #OSNEXUS

- #PCIレーン数

- #人工知能

- #SDS

- #DNN

- #QPU

- #サーバー

- #Windowsアップデート

- #Numecent

- #バックアップ

- #シーゲイト

- #L2 Cache

- #ChatGPT

- #水冷技術

- #NVIDIA Hopper アーキテクチャ

- #NVIDIA B200

- #朝日新聞

- #AVD

- #Azure Virtual Desktop

- #エンタープライズバックアップソリューション

- #EXOS AP

- #ストレージグリッド

- #コンテナ化

- #L4

- #NVLink

- #ProphetStor

- #ICXセンター

- #クラウドVDI

- #DX

- #Veritas NetBackup/BackupExec

- #EXOS CORVAULT

- #セキュリティ

- #OS

- #NVIDIA L4

- #NVSwitch

- #Windows11

- #Windows10サポート終了

- #Windows10リプレース

- #アプリケーション

- #Acronis Backup

- #QuantaStor

- #SaaS

- #Docker

- #冷却機能

- #GPUアーキテクチャ

- #サーバールーム

- #Windows Update

- #マイクロソフト

- #ランサムウェア

- #IBM Spectrum Protect

- #VMware

- #PaaS

- #Kubernetes

- #アプリケーション仮想化

- #vGPU

- #Cloudpaging

- #Intel筐体

- #サイバー攻撃

- #ArcServe

- #vSAN

- #仮想化

- #ITインフラ

- #アプリ仮想化

- #データセンター

- #ソフトウエア・ディファインド・ストレージ

- #AMD筐体

- #情報セキュリティ

- #NAS

- #HCI

- #IaaS

- #NVIDIA A100

- #Citrix

- #オンプレミス

- #ストレージ

- #VMware Explore

- #マルウェア

- #Network Attached Storage

- #Hyperconverged Infrastructure

- #パブリッククラウド

- #レガシーアプリケーション

- #ThinApp

- #エッジコンピューティング

- #ソフトウェア

- #NVIDIA AI Enterprise

- #ExaGrid

- #AI Enterprise

- #仮想化ストレージソリューション

- #ハイブリッドクラウド

- #NVIDIA L40S

- #App-V

- #ニューラルネットワーク

- #ストレージ(ハード)

- #VMware Tanzu

- #Veeam

- #NVAIE

- #Intel Xeon

- #マルチクラウド

- #NVIDIA A40

- #Microsoft Application Virtualization

- #ディープラーニング

アーカイブ

- 2025年1月 (3)

- 2024年12月 (14)

- 2024年11月 (9)

- 2024年10月 (14)

- 2024年9月 (10)

- 2024年8月 (10)

- 2024年7月 (10)

- 2024年6月 (11)

- 2024年5月 (10)

- 2024年4月 (10)

- 2024年3月 (8)

- 2024年2月 (9)

- 2024年1月 (8)

- 2023年12月 (11)

- 2023年11月 (8)

- 2023年10月 (14)

- 2023年9月 (9)

- 2023年8月 (8)

- 2023年7月 (11)

- 2023年6月 (3)

- 2023年5月 (1)

- 2023年4月 (6)

- 2023年3月 (1)

- 2023年2月 (6)

- 2023年1月 (1)

- 2022年12月 (4)

- 2022年11月 (4)

- 2022年10月 (4)

- 2022年9月 (3)

- 2022年8月 (4)

- 2022年6月 (5)

- 2022年5月 (3)

- 2022年4月 (1)

- 2022年3月 (4)

- 2022年1月 (1)

- 2021年11月 (3)