PRODUCT

製品紹介

サーバー(ハードウェア)

NVIDIA データセンターGPU製品

データセンター向けアクセラレーテッド

コンピューティング プラットフォーム

NVIDIA™アクセラレーテッド コンピューティング プラットフォームでは、最新のデータセンターにディープラーニング、機械学習、ハイパフォーマンスコンピューティング(HPC)ワークロードを高速化するパワーがもたらされます。

画期的なイノベーション

- Tensorコア

- MIG

- トレーニング高速化

- NVLink

NVIDIA H100 Tensorコア

- 動的に演算を調整することで正確さを維持しながらスループットを加速化

- 多数のAIおよびハイパフォーマンスコンピューティング (HPC) タスクを高速化

- トランスフォーマーネットワークトレーニングを6倍高速化

- すべてのアプリケーションで 3 倍のパフォーマンス向上

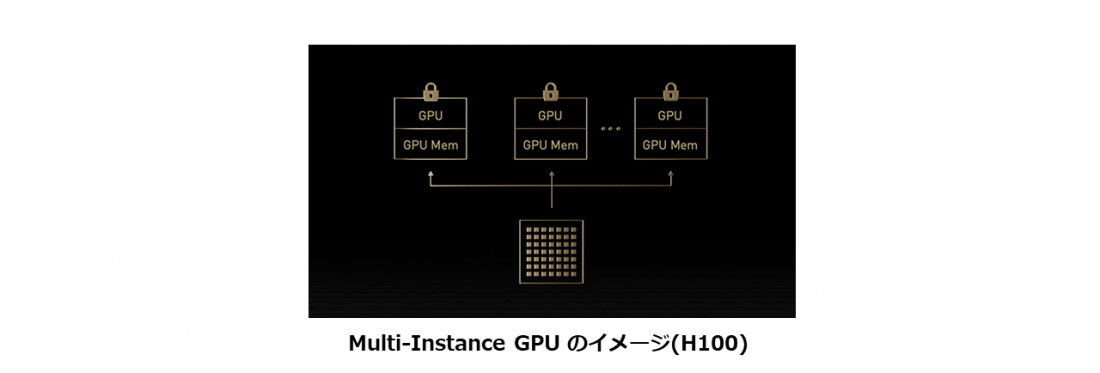

Multi-Instance GPU (MIG)

- GPUを完全に分離された複数の小さなインスタンスに分割

- 各々のGPUにメモリ、キャッシュ、コンピューティングコアを与えます。

- 最大7個のGPUインスタンスで仮想環境のマルチテナント/マルチユーザー構成をサポート

- MIGインスタンスごとに専用のビデオ デコーダーが与えられ、共有インフラストラクチャで安定したハイスループットのインテリジェント ビデオ解析 (IVA) が実現

Transformer Engine

- AIモデルのトレーニングを高速化するように設計されたTransformer Engineとの組み合わせでTensor コアテクノロジを促進

- Hopper TensorコアではFP8とFP16の精度を混在可能

- TransformerのAIコンピュートスピードが劇的に高速化

- Transformer Engine と第4世代 NVIDIA®NVLink®と組み合わせることで Hopper TensorコアはHPCとAIのワークロードを桁違いに高速化

NVLink Switchシステム

- スケールアップに相互接続が可能

- NVLink Switchと組み合わせると、NVLink SwitchシステムはPCIe Gen5の7倍以上の帯域幅でGPUあたり900ギガバイト(GB/s)の双方向で複数サーバーにわたりマルチGPU IOを拡張可能

- 最大256基のH100を接続したクラスターをサポート(前世代のAmpereと比較して約9倍の性能向上)

NVIDIA データセンターGPU製品ご紹介動画

NVIDIA データセンターGPU製品の特長

NVIDIA H100 Tensor コア

Tensorコアは、混合精度のコンピューティングを可能にし、動的に演算を調整することで正確さを維持しながらスループットを加速します。最新世代のTensorコアは、多数のAIおよびハイパフォーマンスコンピューティング (HPC) タスクをこれまで以上に高速化します。トランスフォーマーネットワークトレーニングの6倍の高速化から、すべてのアプリケーションで3倍のパフォーマンス向上まで、NVIDIA Tensorコアは、すべてのワークロードに新しい機能をもたらします。

Multi-Instance GPU (MIG)

Multi-Instance GPU (MIG) は、 A100およびA30のGPUでサポートされている機能であり、ワークロードがGPUを共有することを可能にします。MIGを利用すると、各GPUを複数のGPUインスタンスに分割できます。各インスタンスは完全に分離され、ハードウェアレベルで保護され、専用の高帯域幅メモリ、キャッシュ、コンピューティングコアを与えられます。

Hopper アーキテクチャはMIGの機能をさらに強化し、最大7個のGPUインスタンスで仮想環境のマルチテナント/マルチユーザー構成をサポートします。また、コンフィデンシャルコンピューティングによってハードウェアおよびハイパーバイザーレベルで各インスタンスが分離されるため、非常に安全な構成になっています。MIGインスタンスごとに専用のビデオ デコーダーが与えられ、共有インフラストラクチャで安定したハイスループットのインテリジェントビデオ解析 (IVA) が実現します。そして、Hopperの同時実行MIGプロファイリングを利用することで、管理者はユーザーのために正しいサイズのGPU高速化を監視し、リソース割り当てを最適化できます。

Transformer Engine

NVIDIA Hopperアーキテクチャは、AIモデルのトレーニングを高速化するように設計されたTransformer Engineとの組み合わせで Tensorコアテクノロジを前進させます。Hopper TensorコアではFP8とFP16の精度を混在させることができます。TransformerのAIコンピューティングが劇的に速くなります。Hopper はまた、TF32、FP64、FP16、INT8 の精度の浮動小数点演算 (FLOPS) を前世代に比べ3倍高速化にします。Transformer Engineと第4世代 NVIDIA® NVLink®と組み合わせることでHopper TensorコアはHPCとAIのワークロードを桁違いに高速化します。

NVLink Switch システム

第 4 世代 NVLink は、スケールアップ相互接続です。新しい外部 NVLink Switchと組み合わせると、NVLink Switchシステムは、PCIe Gen5の7倍以上の帯域幅である、GPU あたり 900 ギガバイト/秒 (GB/s) の双方向で複数のサーバーにわたるマルチGPU IO (入出力) を拡張することが可能になりました。NVLink Switch システムは、最大256基のH100を接続したクラスターをサポートし、AmpereでInfiniBand HDRの9倍高い帯域幅を実現します。

さらに、NVLinkはこれまでInfiniBandでのみ利用可能であったSHARPと呼ばれるIn-network Computingをサポートし、57.6テラバイト/秒 (TB/s) の All-to-Allの帯域幅を実現しながら、FP8スパースAIコンピューティングで1 exaFLOPSという驚くべき性能を提供することができるようになりました。

パートナー

関連製品

NVIDIA データセンターGPUをご利用・ご検討のお客様におすすめのソリューション

ソフトウェア

GPU処理高速化ソリューション

Federator.ai GPU Booster

サーバー(ハードウェア)

Supermicro GPUサーバー製品

VDI環境の基盤やAI・ディープラーニング開発など高い演算能力が必要なワークロードに

サーバー(ハードウェア)

Supermicro 汎用サーバー製品

エンタープライズサーバーアプリケーションのための、汎用エントリーレベルと、ボリューム向けサーバー